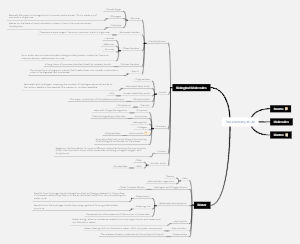

Mindmap-Galerie Autonomic Nervous System (ANS) Drugs

- 1.1k

- 8

- 4

Autonomic Nervous System (ANS) Drugs

This is a mind map talking about the Autonomic Nervous System (ANS) Drugs. You can create a mind map like this effortlessly.

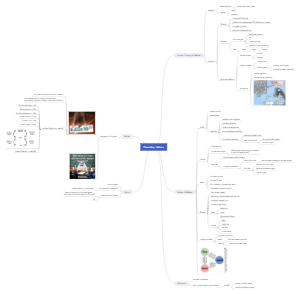

Bearbeitet um 2020-09-28 07:54:18- Creative Halloween Costume Ideas

Halloween has many faces. The theme you envision should influence how you decorate the party space. Jack-o'-lanterns and friendly ghosts are more lighthearted Halloween characters. Zombies, witches, and vampires are much darker. If you want to celebrate all the fun sides of Halloween, then it’s okay to mesh the cute with the frightening. Here is a mind map which lists down the 39 Cutest Couples Halloween Costumes of 2021.

- 35 Best and Classic Halloween Movies

Halloween simply wouldn't be Halloween without the movies that go along with it. There's nothing like a movie night filled with all the greatest chainsaw-wielding, spell-binding, hair-raising flicks to get you in the spooky season spirit. So, break out the stash of extra candy, turn off all the lights, lock every last door, and settle in for the best of the best Halloween movies. Here are the 35 Halloween movies listed on the mind map based on the year of release.

- Halloween Party Ideas Mind Map

This mind map contains lots of interesting Halloween trivia, great tips for costumes and parties (including food, music, and drinks) and much more. It talks about the perfect Halloween night. Each step has been broken down into smaller steps to understand and plan better. Anybody can understand this Halloween mind map just by looking at it. It gives us full story of what is planned and how it is executed.

Autonomic Nervous System (ANS) Drugs

- Creative Halloween Costume Ideas

Halloween has many faces. The theme you envision should influence how you decorate the party space. Jack-o'-lanterns and friendly ghosts are more lighthearted Halloween characters. Zombies, witches, and vampires are much darker. If you want to celebrate all the fun sides of Halloween, then it’s okay to mesh the cute with the frightening. Here is a mind map which lists down the 39 Cutest Couples Halloween Costumes of 2021.

- 35 Best and Classic Halloween Movies

Halloween simply wouldn't be Halloween without the movies that go along with it. There's nothing like a movie night filled with all the greatest chainsaw-wielding, spell-binding, hair-raising flicks to get you in the spooky season spirit. So, break out the stash of extra candy, turn off all the lights, lock every last door, and settle in for the best of the best Halloween movies. Here are the 35 Halloween movies listed on the mind map based on the year of release.

- Halloween Party Ideas Mind Map

This mind map contains lots of interesting Halloween trivia, great tips for costumes and parties (including food, music, and drinks) and much more. It talks about the perfect Halloween night. Each step has been broken down into smaller steps to understand and plan better. Anybody can understand this Halloween mind map just by looking at it. It gives us full story of what is planned and how it is executed.

- Für Sie empfohlen

- Gliederung

Autonomic Nervous System (ANS) Drugs

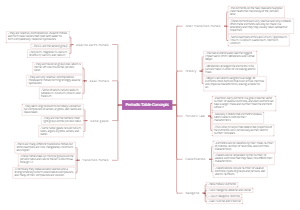

Adrenergic Pharmacology

- Sympathetic Agonists

- Non specific

- Epinephrine is a direct stimulator at all adrenergicreceptors. In addition to local vasoconstriction, it isindicated for hypotension and shock, allergy, andbronchoconstriction.

- Epinephrine Indications:

Local Vasoconstriction

Hypotension and Shock

Bronchoconstriction

Allergy

Mechanism:

Direct stimulation of α and βadrenergic receptors

- The Epi-Pen is used in cases of severebrochoconstriction either from allergy(anaphylaxis) or from an asthma exacerbation.

- Image of an EpiPen

- Disease Related Concerns

Cardiac: β1 stimulation increases the workof the heart and decreases cardiacefficiency

• Cerebrovascular disease: Use withcaution in patients with cerebrovasculardisease

• Diabetes: Increases in circulating bloodglucose from stimulation of liver glycogenolysisand glucagon secretion Inhibition of insulinsecretion

• Parkinson's disease: may causetemporary worsening ofsymptoms.

• Thyroid disease: Use withcaution in patients with thyroiddisease

- Antidepressants: Include include the tricyclics and theserotonin-norepinephrine reuptake inhibitors (the SNRIs). Theseblock reuptake and degradation of epi, leading to more cardiacadverse effects

β-Blockers: Non-Selective: Block β receptors inthe peripheral blood vessels, epi acts as a pureα agonist and blood pressure rises

Selective Block β1 receptors in heart, at highdoses block β 2 receptors in peripheral bloodvessels

- Alpha α

- α Sympathetic Agonists

Methylphenidate (Ritalin), (Concerta)

Amphetamine (Adderall)

Mechanism: Release of Norepifrom synaptic vesicle

Use: ADHD and Narcolepsy

- The FDA asked the Drug Safety and RiskManagement advisory committee to look intostudying the cardiac risk in both adult and childrentaking ADHD drugs:

* sudden death in patients whohave heart problems or heartdefects

* stroke and heart attack in adults

* increased blood pressure andheart rate

Abuse and addiction: Schedule2 (Ritalin and Adderall)

Dyskinesia, muscle tightness, bruxism

- Provigil (Modafinil)

MOA: α 1 agonist, inhibitor ofdopamine reuptake

Indication: narcolepsy, shift work disorder

Adverse Effects: mania, delusions, hallucinations,suicidal ideation and aggression, persistentsleepiness

Provigil is a drug that is similar to Ritalin. It is also indicated for narcolepsy. Its otherindication is shift work disorder. Shift work disorder is a circadian rhythm sleep disordercharacterized by insomnia and excessive sleepiness affecting people whose work hoursoverlap with the typical sleep period. Provigil is an alpha 1 agonist and an inhibitor ofdopamine reuptake. It has many adverse effects mainly in the CNS including mania, delusionsand hallucinations.

- Catapres is an inverse agonist. This means that is binds to receptors as an agonist but has theopposite effects that you would expect from an agonist. Catapres binds to alpha 2 receptorson the pre-synaptic neuron. This causes a negative feedback signal that inhibits the release ofnorepinephrine into the synapse. Less norepinephrine means that blood pressure willdecrease. Catapres is indicated for hypertension and can cause dry mouth and orthostatichypertension.

- Alpha Adrenergic Synapse Image

- Beta β

- β2 Sympathetic Agonist

There is only 1 drug in the beta sympathetic agonist drug class that is widely used. It is Proventil. It binds specifically to beta 2 receptors. It is indicated for asthmaand COPD. It is available in an inhaler. The beta 2 receptors in the lungs willreceive most of the drug. This decreases the chance for adverse effects in the restof the body.

- Sympathetic Antagonists

- Alpha α

- When drugs are antagonists in the sympatheticarm of the ANS, their effects are like that ofacetylcholine.

- Effects of Acetylcholine:

Bradycardia

Vasodilation

Bronchoconstriction

Relaxation of urinary sphincter

Increase GI secretions

Sweating

Contraction of iris

SLUD Response:

Salivation

Lacrimation

Urination

Defecation

- Drugs that are antagonists of adrenergicreceptors are used most commonly in heartdisease and benign prostatic hyperplasia (BPH).

- Therapeutic Uses of Drugs atAdrenegeric Receptors(Antagonists)

HTN, Post myocardial infarction, CHF,Treatment of arrhythmias, Ischemic heartdisease

α blocker: Hytrin

β blockers: Toprol, Propranolol, Coreg

Benign prostatic hyperplasia:

α blocker: Hytrin, Flomax

- Hytrin and Flomax are alpha sympathetic antagonists that are used treat BPH. Hytrin is alsoused to treat HTN. Hytrin is the drug of choice when a patient has both BPH and HTN. Both ofthese agents block alpha receptors which leads to smooth muscle relaxation. Flomax targetsreceptors alpha receptor subtypes that are found only in the prostate gland. As aconsequence, patients on Flomax may experience fewer adverse effects than patients on Hytrin.

- Beta β

- Remember that sympathetic antagonists have the effects of acetylcholine. Thislists the therapeutic effects of beta blockers. The most important one is thatcardiac output decreases. The exact signal transduction steps between thebinding of the beta receptor by a beta blocker and the pharmacological effectsare unknown.

PCOL Effects of Beta Blockers

↓ the force and rate of myocardial contraction

↓ O2 consumption of the heart

↓ of blood pressure in hypertensive patients

CO decreases

HR decreases

Reduction in plasma renin activity

Decrease CNS sympathetic outflow

Alteration in baroreceptor responsiveness

- There are two classes of betablockers: selective andnonselective.

- Selective for β1

Selective beta blockers bind at the beta 1 receptor in the heart. Themechanism of action is competitive inhibition of epinephrine andnorepinephrine at the beta 1 receptor. Selective beta blockers likeToprol are almost always used to treat heart disease or hypertension.

- Nonselective

The non-selective beta blockers like Inderal block both beta 1and beta 2 receptors. Non-selective beta blockers can be used totreat heart disease and also a number of other conditions, forinstance migraines, stage fright or tremor.

- Beta blockers are well tolerated,but do have a few adverse effects.

Adverse effects:

Altered taste

Orthostatic hypotension

Non-Selective:

hypertension and bradycardia

- β Antagonists

Carvedilol (Coreg) is a unique beta blocker in that it also blocksalpha receptors. It decreases heart rate and contractility and alsodecreases blood pressure through alpha blockade. It is mostcommonly used in heart failure.

Cholinergic Pharmacology

- Drugs that act at cholinergic receptors have a mechanism ofaction that drugs that act at adrenergic receptors do not have. Cholinergic drugs are able to inhibit the breakdown ofacetylcholine by inhibiting the action of cholinesterase.

- Diagram of cholinergic synapse

- Parasympathetic Agonists

- Review of pharmacological effects thatcholinergic agonists might produce in thebody:

Effects of Acetylcholine:

Bradycardia

Vasodilation

Bronchoconstriction

Relaxation of urinary sphincter

Increase GI secretions

Sweating

Contraction of iris

SLUD Response:

Salivation

Lacrimation

Urination

Defecation

- Cognex, used for Alzheimer's, is themost predominant drug in this class.

- Cholinergic drugs have 2 possible mechanisms by which they ace. They can inhibit cholinesteraseto increase the half life of acetylcholine at the receptor site or they can be direct acting by bindingto and stimulating the cholinergic receptors. Cholinergic drugs are not well tolerated. They arecontraindicated in asthma, cardiovascular disease and ulcer. The adverse effects include theparasympathetic reactions of the SLUD response as well as many more, including nausea, diarrhea,vomiting, rhinitis, urinary frequency, bronchospasm, hypotension, arrhythmias

- Tacrine (Cognex) is a cholinesterase inhibitor. Itis used in dementia associated with Alzheimer’sdisease or Parkinson’s disease.

Idea: Prolong acetylcholine half life in the brain

- Parasympathetic Antagonists

- Expect these drugs to have the samepharmacological effects of the sympatheticagonists.

- Review of the pharmacological effects ofnorepinephrine. These are the therapeuticeffects of the parasympathetic antagonists:

Tachycardia

Vasoconstriction

Bronchodilation

Contraction of urinary sphincter

Decreased GI secretions

Glycogenolysis

Gluconeogenesis

Lipolysis

- General therapeutic uses of antimuscarinic drugs:

Bronchodilation: Asthma and COPD

* Ipratropium (Atrovent)

* Tiotropium (Spiriva)

Urinary: antispasmodics

* Tolterodine (Detrol)

* Darifenacin (Enablex)

- Atrovent is a drug that blocks the cholinergic receptors in the lungs. The causesbronchodilation. It is available on its own in an inhaler or as a combinationproduct with albuterol in the Combivent inhaler. Spiriva is also a drug that blocksthe cholinergic receptors in the lungs, but it has a much longer half-life thenAtrovent. It is used as once daily dosing in patients that have COPD.

- M3 is the cholinergic receptor found in theurinary sphincter muscle. Enablex has lessadverse effects than Detrol, less dry mouth andconstipation.

- Anticholinergic drugs can interact with antihistamines. This interaction canlead to severe dry mouth. Enablex is a CYP2D6 inhibitor. This is the P450enzyme in the liver that is responsible for the metabolism of codeine. If apatient is taking Enablex, codeine may not be effective to control dentalpain.