Galería de mapas mentales A mind map of Portuguese

A mind map of Portuguese

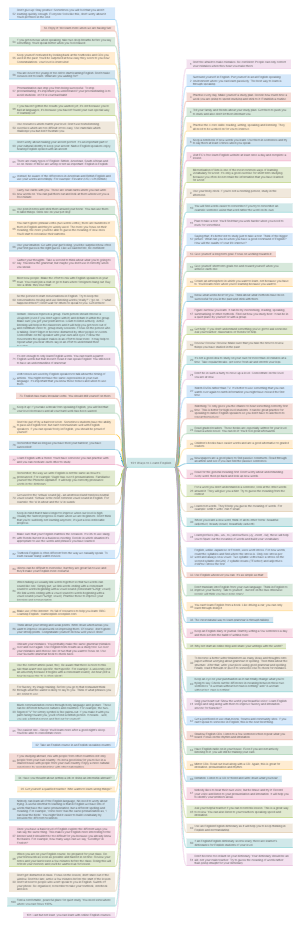

This mind map clearly outlines various aspects of the Portuguese language, including key topics such as reasons for decline, positive impacts, and introductions to personalities, with detailed analyses of management methods, authoritarian states, and architectural techniques. The map presents information through a radial structure centered on the core topics, consisting of themes, branches, and keywords, mimicking the neural network of the brain to aid in memory reinforcement, information integration, and creativity stimulation.

Editado a las 2023-05-13 05:28:51,A mind map of Portuguese

- Recomendados

- Resumen